요약

대형언어모델의 환각 현상은 주로 학습 데이터의 오류와 모델의 과도한 확신에서 비롯됩니다. 이러한 환각을 완화하기 위해 검색 기반 생성(RAG), 인간 피드백 기반 강화 학습(RLHF), 고품질 데이터를 활용한 미세조정 등 다양한 전통적인 기법들이 활용되어 왔으며, 이를 보완하기 위한 새로운 연구들도 활발히 진행되고 있습니다.

대형 언어 모델(LLM)의 환각(Hallucination) 현상

본 글은 최근 발표된 세 편의 논문을 바탕으로 작성되었습니다.

- Song, L., Shi, T., & Zhao, J. (2025), The Hallucination Tax of Reinforcement Finetuning

- Zheng, H., Xu, H., Liu, Y., Chen, L., Fung, P., & Yu, K. (2025), Enhancing LLM Reliability via Explicit Knowledge Boundary Modeling

- Kumar, A., Kim, H., Nathani, J. S., & Roy, N. (2025), Improving the Reliability of LLMs: Combining Chain-of-Thought Reasoning and Retrieval-Augmented Generation

대형 언어 모델(LLM)은 방대한 데이터를 학습하여 인간과 유사한 문장을 생성할 수 있는 능력을 갖추었지만, 종종 실제 사실과 일치하지 않는 그럴듯한 출력을 만들어내기도 합니다. 이를 환각(hallucination)이라 하며, 사용자에게는 설득력 있어 보이지만 사실에 근거하지 않은 정보를 생성하는 현상입니다. 예를 들어, 약물의 부작용에 대해 잘못된 내용을 자신 있게 제시하거나, 존재하지 않는 법적 판례를 만들어내는 경우입니다. LLM은 확률적 예측 기반으로 작동하기 때문에, 생성된 내용의 진위를 스스로 판단하거나 검증하지 못합니다. 이러한 환각 현상은 LLM의 신뢰성(reliability)을 심각하게 저해하는 문제로, 임상·법률·금융 등 정밀한 정보가 요구되는 분야에서 특히 위험할 수 있습니다.

환각 발생의 기술적 원인

LLM 환각의 원인은 다양하지만, 크게 다음의 세 가지로 요약할 수 있습니다.

- 학습 데이터의 품질 문제

- 모델이 학습한 데이터에 부정확하거나 편향된 정보가 포함된 경우, 그 오류가 그대로 재생산될 수 있습니다. 부정확한 인터넷 자료나 오래된 정보가 데이터에 섞여 있다면, 모델은 이를 사실로 학습하여 잘못된 정보를 생성하게 됩니다.

- 과도한 확신 문제

- LLM은 자신이 알고 있는 것과 모르는 것을 구분하지 못하고 무조건 답변을 제공하려는 경향이 있습니다. 모델의 출력은 ‘가장 그럴듯한 다음 단어’를 예측하는 방식이기 때문에, 자신의 지식 한계나 불확실성을 고려하지 않고 높은 확률의 결과를 제시합니다. 이로 인해 틀린 정보도 매우 확신에 찬 어조로 전달되어 마치 사실처럼 보이게 됩니다.

- 실시간 검증 메커니즘의 부재

- LLM은 학습한 데이터 외에는 외부 정보 확인 능력이 없습니다. 생성된 내용이 사실인지 확인하는 내부 시스템이나 외부 데이터 연동 기능이 없기 때문에, 오류를 걸러낼 수 없습니다. 즉, 모델 스스로 사실 여부를 확인하거나 수정할 수 없기 때문에, 잘못된 정보를 ‘검증 없이’ 그대로 출력하게 됩니다.

이 외에도 모델 크기 증가로 인해 기억 능력은 향상되었지만, 미지의 지식(knowledge boundary)에 대한 인식은 오히려 부족해지는 현상도 나타납니다. 모델이 자신이 알지 못하는 질문에 대해서도 무작정 답변을 시도하기 때문에, 정답이 존재하지 않는 질문에 대해서도 그럴듯한 답변을 만들어내는 것입니다.

환각 현상 완화를 위한 전략

기존 접근법

환각 문제를 완전히 제거하기는 어렵지만, 다양한 기법을 통해 발생 빈도를 줄일 수 있습니다. 주요 접근 방식은 다음과 같습니다.

- 고품질 데이터로 미세조정(Fine-Tuning)

- 학습 데이터의 품질을 높이면 모델의 출력을 더 정확하게 만들 수 있습니다. 검증된 신뢰할 만한 자료를 선별하여 모델을 미세조정하면, 잘못된 정보를 학습할 가능성이 줄어들어 환각 현상을 감소시킬 수 있습니다. 예를 들어, 의료 문헌이나 공식 기록 등 정확한 데이터를 사용해 추가 학습을 진행하면, 모델이 오류 있는 정보에 노출될 확률을 줄일 수 있습니다.

- 인간 피드백 기반 강화 학습(RLHF, Reinforcement Learning from Human Feedback)

- 인간 평가자가 모델의 출력을 평가하고 피드백을 제공하여, 이를 강화 학습 과정에 반영하는 방법입니다. RLHF에서는 평가자가 모델의 응답을 점수화하여 부정확한 답변에는 페널티를 부여하고, 올바른 답변에는 보상을 제공합니다. 이를 통해 모델이 점차 유용한 답변을 학습하게 되며, 부정확한 출력을 줄일 수 있습니다. GPT-4도 RLHF를 통해 반복 학습을 거치며 출력 품질을 향상시킨 것으로 알려져 있습니다.

- 검색 증강 생성(RAG, Retrieval-Augmented Generation)

- 모델이 자신의 기억에만 의존하지 않고 외부 데이터베이스나 문서를 참조하도록 하는 기법입니다. RAG를 적용하면, 모델이 사용자 질문에 답할 때 신뢰할 수 있는 외부 소스(예: 위키피디아, 논문 등)에서 관련 정보를 검색하여 활용하게 됩니다. 이를 통해 모델의 지식 한계를 보완하고, 생성된 문장을 사실 기반으로 교정할 수 있습니다. 단점으로는 대규모 검색 처리가 필요해 계산 비용이 많이 든다는 점이 있습니다.

- 사후 필터링 및 교정

- 모델 출력을 직접 검증하는 단계로, 규칙 기반 필터나 추가적인 점수화 과정을 활용합니다. 예를 들어, 생성된 여러 후보 답변을 문장 유사도나 사실 검증 알고리즘으로 재평가하여 가장 신뢰할 수 있는 답변을 선택하거나, 비현실적이거나 근거 없는 답변을 제거합니다. 또한, 모델의 신뢰도 보정(calibration) 기법도 적용됩니다. 모델이 각 답변에 자신감 점수를 부여하도록 학습시키거나, 온도 파라미터(Temperature Parameter)를 조정하여 출력을 덜 무작위적으로 만들면, 낮은 확률의 답변이 줄어들어 허위 응답 가능성이 감소합니다.

이처럼 고품질 데이터 미세조정, RLHF, RAG, 검증 시스템 등의 다양한 방법이 환각을 줄이는 데 활용되고 있습니다. 다만, 이들 방식은 계산 비용 증가, 모델 유연성 저하 등의 한계도 존재합니다. 예를 들어 RAG는 외부 지식 조회에 많은 연산이 필요하고, RLHF는 다수의 인간 평가 작업이 필요하여 비용이 많이 듭니다. 그럼에도 의료, 금융, 법률처럼 높은 정밀도가 요구되는 분야에서는 이러한 기법들이 필수적으로 사용되고 있습니다.

논문 분석

The Hallucination Tax of Reinforcement Finetuning

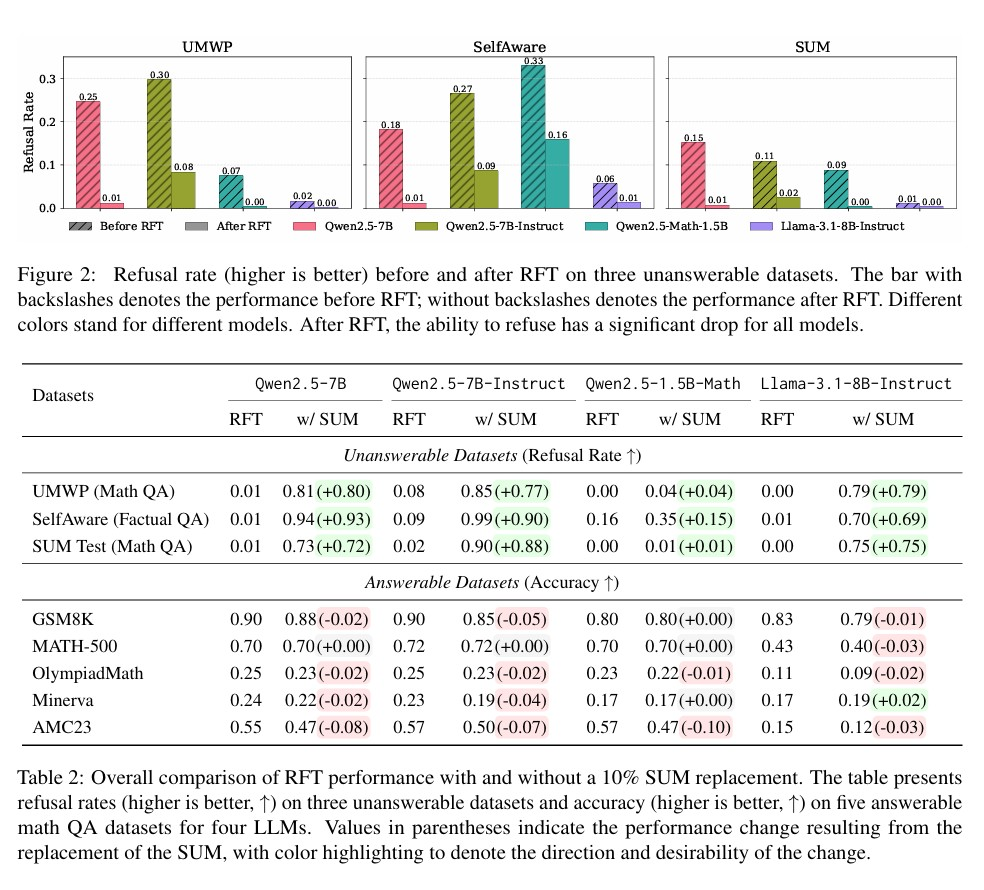

강화 학습 파인튜닝(Reinforcement Finetuning, RFT)이 모델의 추론 능력을 높이는 대신, 의도치 않은 부작용을 유발할 수 있다는 연구 결과가 발표되었습니다. 연구진은 표준 RFT를 적용한 모델들이 답이 불분명하거나 정보가 부족한 질문에 대해 “모르겠다”라고 답하는 대신, 허구의 답변을 자신 있게 제공하는 “환각 세금(hallucination tax)” 현상을 발견하였습니다. 구체적으로, RFT 학습을 거친 모델은 답이 없는 문항에 대해 거절률(refusal rate)이 80% 이상 감소하였으며, 환각성 답변율은 오히려 증가하였습니다.

이 문제를 해결하기 위해 연구진은 Synthetic Unanswerable Math (SUM)라는 합성 수학 문제 데이터를 사용하였습니다. SUM은 일부 정보가 의도적으로 누락되어 풀 수 없는 수학 문제들로 구성되어 있으며, 모델이 “답할 수 없다”라고 판단하고 거부 응답을 할 수 있도록 훈련됩니다. 훈련 데이터에 SUM 문제를 10% 포함해 학습한 모델은 답이 없는 문항에서 적절히 “모르겠다”라고 응답하는 비율이 높아졌고, 환각성 답변은 줄어들었습니다. 이와 같은 학습 방식은 모델의 성능 저하 없이 일반적인 문항에서도 불확실성을 인식하고 신중하게 응답하는 능력을 향상시켰습니다.

연구진은 이러한 문제가 RFT의 보상 함수와 모델의 불확실성 인식 부족 사이의 불일치에서 기인한다고 분석하였습니다. 기존 RFT는 정답을 맞히는 성과에만 보상을 부여하기 때문에, “모르겠다”라는 반응에는 보상이 주어지지 않으며, 오히려 어떤 경우에도 답변을 시도하려는 학습이 유도됩니다. 본 연구는 강화 학습 과정에서도 모델이 자신의 지식 한계를 인식하고 적절히 거절할 수 있도록 학습하는 것이 중요함을 보여주었습니다.

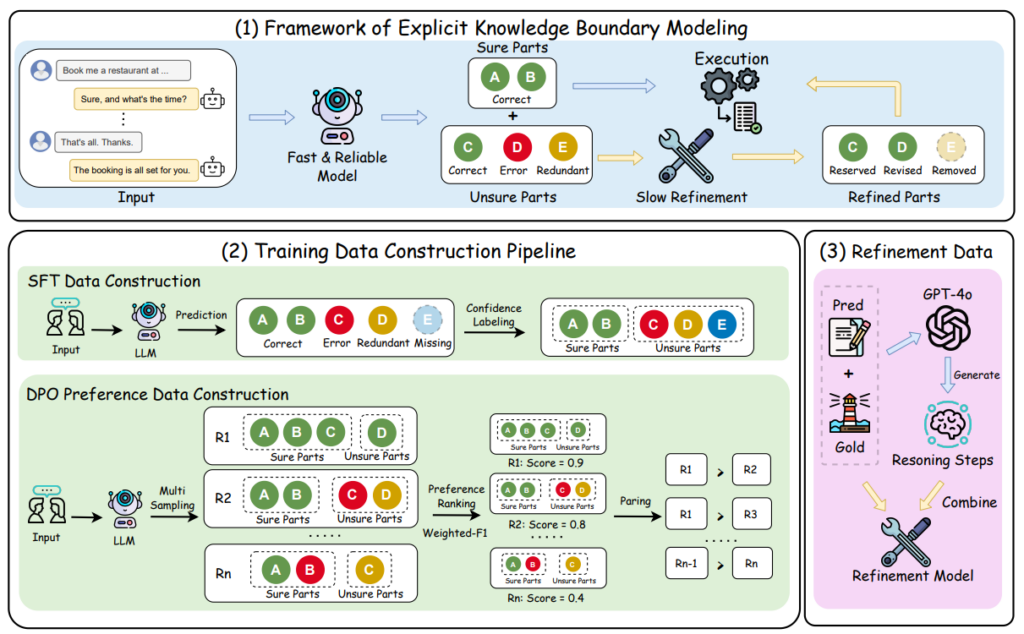

Enhancing LLM Reliability via Explicit Knowledge Boundary Modeling

대형 언어 모델(LLM)은 학습되지 않은 주제나 범위를 벗어난 질문에 대해 부정확한 답변을 생성하며, 이는 사용자에게 혼란을 줄 수 있습니다. 기존 방법들은 불확실성을 기반으로 응답을 거절하거나 추론을 지연하지만, 오차가 있거나 활용도가 떨어진다는 한계가 있습니다. 이 문제를 해결하기 위해 연구자들은 Explicit Knowledge Boundary Modeling (EKBM) 프레임워크를 소개합니다. 이 프레임워크는 “빠른 추론” 모델이 먼저 자신 있는 답변(‘sure’)을 생성하고, 자신 없는 경우 ‘느린 추론’ 모델이 추가적인 검증 과정을 거쳐 답변을 보강하도록 설계되었습니다.

EKBM은 두 단계로 나뉘어 작동합니다. 첫 단계에서는 빠른 모델이 답변과 함께 자신감 레이블(‘sure’ 또는 ‘unsure’)을 알려줍니다. 자신 있는 경우 바로 응답을 제공할 수 있고, 자신 없는 경우 다음 단계로 넘어가게 됩니다. 두 번째 단계에서는 느린 모델이 해당 답변을 정교하게 다듬어 정확성을 높이며, 이 방식은 신뢰성과 실용성의 균형을 맞추는 데 중점을 둡니다.

연구자들은 EKBM을 dialogue state tracking(DST) 태스크에 적용하여 다른 불확실성 기반 기법 대비 뛰어난 신뢰성(Quality‑F1 기준)과 정확성을 입증했습니다. 특히 추가 검증 단계는 계산 비용을 많이 증가시키지 않으면서도 응답의 정확도를 크게 개선했습니다. 이를 통해 본 연구는 정확도, 속도, 활용성 간 균형을 이루는 신뢰성 높은 LLM 설계의 새로운 방향성을 제시합니다.

Improving the Reliability of LLMs: Combining Chain-of-Thought Reasoning and Retrieval-Augmented Generation

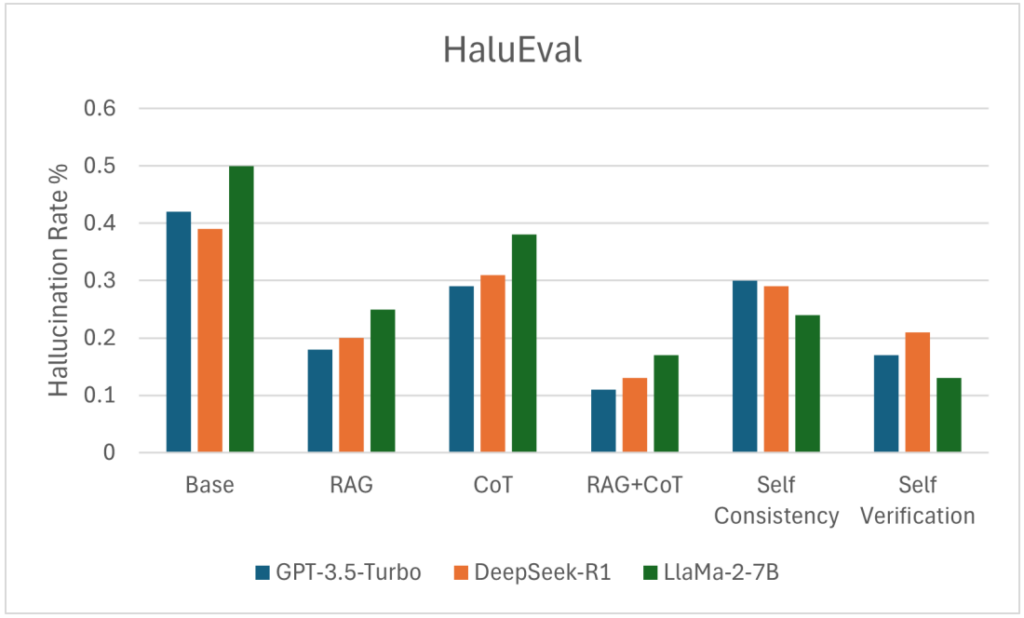

LLM의 환각 문제를 해결하기 위해 연구자들은 분석 단계를 거쳐 사고의 흐름(chain-of-thought, CoT)을 유도하고, 외부 지식을 참조하는 검색 기반 생성(RAG) 방식과 결합했습니다. 또한, 자기 일관성(self-consistency)과 자체 검증(self-verification) 메커니즘을 함께 적용하여, LLM이 스스로 결과를 여러 번 생성하고, 가장 일관성 있는 답변을 선택하거나, 자신의 답을 검증하도록 설계했습니다.

연구진은 HaluEval, FEVER, TruthfulQA라는 세 가지 검증 벤치마크를 활용해 여러 실험을 수행했습니다. CoT와 RAG를 함께 쓰면 환각 발생률이 눈에 띄게 줄었고, 자기 일관성과 자체 검증 방식을 추가하면 객관적인 정확도가 더욱 크게 개선되는 결과를 얻었습니다. 실제로 HaluEval에서는 CoT+RAG+자체 검증이 11%라는 최저 환각률을 기록했고, FEVER와 TruthfulQA에서는 자체 검증 방식이 가장 높은 성능을 보인 것으로 나타났습니다.

분석 결과, CoT는 추론의 깊이를 더하고, RAG는 외부 지식으로 출력을 견고하게 하며, 자기 일관성과 자체 검증은 LLM이 스스로 오류를 줄이는 데 크게 기여한다는 점이 확인되었습니다. 특히, 여러 번 답변을 생성해 일관된 응답을 선택하거나, 답변이 틀렸는지 스스로 확인하는 과정은 환각 현상을 효과적으로 억제했습니다. 다만 이러한 방식은 실행 시간이 늘어나고 계산 자원이 많이 소모된다는 한계도 존재하며, 저자들은 향후 다양한 언어, 모델 조합 및 효율 최적화 연구가 필요하다고 제안합니다.

Conclusion

대형 언어 모델(LLM)의 환각 현상은, 겉보기에는 자연스럽고 설득력 있는 문장을 생성하더라도 실제 사실과 일치하지 않는 정보를 포함할 수 있다는 점에서, 실제 사용에서 큰 제약 요인이 되고 있습니다. 우리는 이러한 환각이 주로 학습 데이터의 오류, 모델의 과도한 확신 편향, 그리고 사실 검증 기능의 부재에서 비롯되며, 이를 완화하기 위한 다양한 기술적 접근이 시도되고 있음을 확인하였습니다. 대표적인 방법으로는 고품질 데이터 기반 미세조정(Fine-Tuning), 인간 피드백 기반 강화 학습(RLHF), 검색 증강 생성(RAG), 사후 필터링 및 자체 검증(Self-Verification) 등이 있습니다.

특히 최근 연구에 따르면, 강화 학습 기반의 파인튜닝(RFT)이 오히려 모델의 거절 능력을 약화시켜, 정답이 존재하지 않는 상황에서도 억지로 응답을 생성하게 되는 ‘환각 세금(Hallucination Tax)’ 현상을 유발할 수 있음이 밝혀졌습니다. 이에 따라, 정답이 존재하지 않는 합성 문항 데이터(SUM)를 학습에 포함해 모델이 불확실성을 인식하고 스스로 응답을 유보하는 능력을 갖추도록 훈련하는 방식이 효과적인 대안으로 제시되었습니다.

또한, 환각 빈도 자체를 줄이는 것을 넘어서 LLM이 신뢰받는 AI로 자리매김하기 위해서는, 모델 스스로의 한계를 인식하고 신중한 응답을 선택할 수 있는 자기 인식 능력, 내부 추론 과정을 외부에서 확인하고 검증할 수 있는 투명성, 외부 지식 출처와의 실시간 검증 및 교차 참조 기능이 모두 갖추어져야 합니다.

향후 LLM이 의료, 금융, 법률과 같은 고정밀, 고책임 분야에서 안전하게 활용되기 위해서는, 이러한 기술적 기반 위에 설계 초기부터 책임성과 검증 가능성을 내장한 개발 프레임워크가 요구됩니다. 환각 문제의 해결은 단순히 모델 성능을 개선하는 차원을 넘어, 인간과 협업할 수 있는 신뢰성 높은 AI 시스템을 구축하기 위한 기반 기술로 작용하게 될 것입니다. 이는 곧, 책임 있는 AI 개발과 사회적 신뢰 확보라는 더 큰 과제를 해결하기 위한 핵심적인 단계이기도 합니다.

References

- Sapien. (2024), Key Techniques for Reducing Hallucinations in Large Language Models

- Song, L., Shi, T., & Zhao, J. (2025), The Hallucination Tax of Reinforcement Finetuning

- Zheng, H., Xu, H., Liu, Y., Chen, L., Fung, P., & Yu, K. (2025), Enhancing LLM Reliability via Explicit Knowledge Boundary Modeling

- Kumar, A., Kim, H., Nathani, J. S., & Roy, N. (2025), Improving the Reliability of LLMs: Combining Chain-of-Thought Reasoning and Retrieval-Augmented Generation