요약

워크플로 자동화 도구 n8n의 강점을 분석하고, AI 에이전트 시대에 API와 MCP를 효과적으로 활용할 수 있는 전략을 제시합니다.

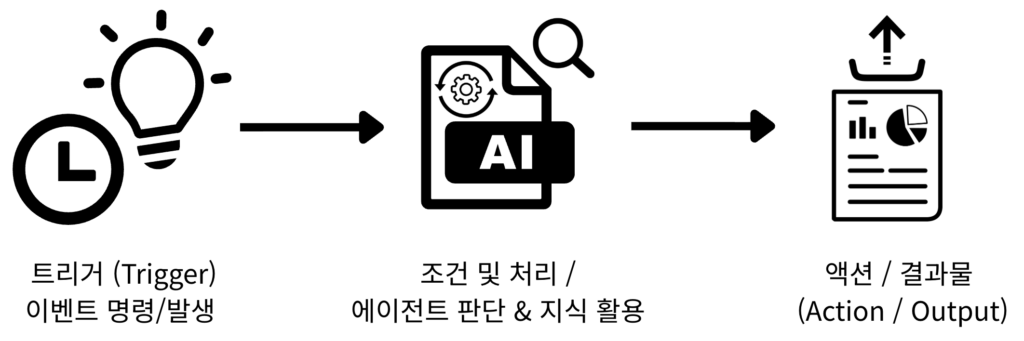

워크플로 자동화 도구의 기본 역할

워크플로 자동화 도구는 반복적인 다양한 업무 프로세스를 자동화해주는 도구로 다양한 애플리케이션과 서비스 간의 데이터 연결을 돕고 자동화된 작업을 구성하는 역할을 합니다.

n8n은 코딩 없이 드래그 앤 드롭 방식으로 쉽게 워크플로를 제작할 수 있는 워크플로 자동화 도구 중 하나입니다. n8n은 이러한 기본 역할에 충실하면서도, ‘기술적 깊이’와 ‘개방성’을 통해 시장의 다른 도구들과 차별화됩니다. 기존의 자동화 도구들이 간편성을 최우선 가치로 내세웠다면, n8n은 복잡한 비즈니스 로직과 엔터프라이즈급 요구사항을 충족시키는 데 중점을 둡니다. 이는 n8n이 단일 작업의 효율성 증대를 넘어, 기업의 운영 시스템을 근본적으로 혁신하는 전략적 도구로 자리매김할 수 있는 기반이 됩니다.

1. n8n의 경쟁 우위 분석

1-1. 핵심 철학 및 아키텍처

n8n의 가장 근본적인 차별점은 오픈소스 라이선스와 자체 호스팅 옵션에 있습니다. 이는 단순한 배포 방식의 차이를 넘어, 사용자에게 전례 없는 통제권, 유연성, 그리고 데이터 주권을 부여하는 전략적 자산입니다.

n8n은 소스 코드가 GitHub에 공개되어 있어, 기술팀이 플랫폼의 내부 동작을 완전히 이해하고 필요에 따라 수정할 수 있는 투명성을 제공합니다. 더 중요한 것은 자체 호스팅을 통해 모든 워크플로와 데이터를 자체 서버나 프라이빗 클라우드에 보관할 수 있다는 점입니다. 이는 GDPR, CCPA와 같은 엄격한 데이터 보호 규정을 준수해야 하는 기업에게는 필수적인 요건이며, 단순히 빌려 쓰는 서비스가 아닌 기업 고유의 경쟁력을 형성하는 독점적인 인프라 자산으로 변모합니다.

이러한 구조는 ‘자체 호스팅’을 단순한 배포 옵션이 아닌, 강력한 ‘전략적 해자(Moat)’로 만듭니다. 클라우드 기반 자동화 도구들이 기능과 통합 앱의 수로 경쟁하는 동안, n8n은 기업이 완전히 사적이고, 고도로 맞춤화되었으며, 깊숙이 내재된 자동화 인프라를 구축할 수 있게 합니다. 이 인프라는 외부 클라우드 서비스에서는 실행하기 너무 위험하거나 불가능한 핵심적이고 민감한 프로세스를 자동화할 수 있게 해줍니다. 앞으로 AI가 워크플로에 더욱 깊이 통합되고 독점적인 내부 데이터로 모델을 훈련시키는 시대가 도래하면, 이러한 비공개 자체 호스팅 환경의 가치는 기하급수적으로 증가할 것입니다. 민감한 내부 데이터를 제3자 클라우드 플랫폼을 통해 외부 AI 모델로 전송하는 것을 꺼리는 기업들에게 n8n의 아키텍처는 미래를 대비한 최적의 선택이 될 것입니다.

1-2. 기술적 유연성 및 확장성

n8n은 처음부터 개발자를 염두에 두고 설계되었으며, 완전한 코드 지원과 확장성을 통해 Zapier나 Make가 제공할 수 없는 수준의 유연성을 자랑합니다.

n8n은 Function 노드 내에서 완전한 JavaScript 및 Python 코드를 지원하여, 기본 노드로는 구현할 수 없는 동적인 데이터 조작이나 커스텀 로직을 구현할 수 있게 해줍니다. 자체 호스팅 환경에서는 외부 npm 또는 PyPI 라이브러리를 설치하여 기능을 극적으로 확장할 수 있으며, 사용자는 어떤 API나 서비스와도 통합할 수 있는 커스텀 노드를 직접 제작할 수도 있습니다.

n8n의 깊이 있는 코드 통합은 중요한 ‘탈출구(Escape Hatch)’ 원칙을 제공합니다. 워크플로의 90%는 시각적 노드로 빠르게 구축하더라도, 가장 핵심적인 10% 고유한 비즈니스 로직, 커스텀 데이터 변환, 레거시 시스템 호출은 코드로 직접 해결할 수 있습니다. 이는 플랫폼의 한계에 부딪혀 프로젝트를 포기하거나 복잡한 외부 솔루션(예: 별도의 클라우드 함수)을 만들어야 하는 상황을 방지합니다. n8n에서는 Code 노드를 추가하고 필요한 코드를 작성하여 워크플로의 맥락 안에서 문제를 직접 해결할 수 있습니다.

이러한 특징은 n8n을 시각적 자동화의 속도와 전통적인 프로그래밍의 힘을 결합한 ‘하이브리드 개발 환경’으로 만듭니다. 이 하이브리드적 성격이야말로 기성 솔루션만으로는 해결하기 어려운 복잡한 비즈니스 프로세스 자동화(Complex Business Process Automation) 문제를 해결할 수 있는 n8n의 핵심 역량입니다.

1-3. 사용 사례별 최적의 도구 선택 가이드

n8n, Zapier, Make 중 어떤 도구를 선택할지는 전적으로 사용 사례, 팀 구성, 그리고 기술적 요구사항에 따라 달라집니다.

- n8n 최적 사용 사례: 복잡한 비즈니스 로직, 대용량 데이터 처리, 엄격한 데이터 프라이버시(GDPR 등)가 요구되는 프로젝트, 그리고 고급 맞춤화가 필요한 기술팀에게 최적입니다.

- Zapier 최적 사용 사례: 표준 SaaS 애플리케이션 간의 빠른 통합, 비기술적인 팀, 그리고 구현 속도가 가장 중요한 단순하고 낮은 볼륨의 자동화에 완벽합니다.

- Make 최적 사용 사례: 중급 사용자, 명확한 시각적 개요가 필요한 정교한 데이터 변환, 그리고 기능과 비용 효율성 사이의 균형을 맞추고자 할 때 이상적입니다.

1-4. 자동화 도구 기능, 가격, 대상 사용자 비교 분석표

| 기준 | n8n | Make | Zapier |

|---|---|---|---|

| 핵심 철학 (Core Philosophy) | 오픈소스, 개발자 우선, 프로세스 중심 | 시각적, 강력함, 균형 잡힘 | 사용자 친화적, 통합 우선, 태스크 중심 |

| 자체 호스팅 (Self-Hosting) | 지원 (무료 커뮤니티 에디션) | 미지원 | 미지원 |

| 가격 모델 (Pricing Model) | 셀프 호스트 무제한 무료 워크플로 실행 당 | 오퍼레이션 당 | 태스크 당 |

| 기술적 유연성 (Technical Flexibility) | 높음 (JS/Python, 커스텀 노드) | 중간 (시각적 로직, 제한된 코드) | 낮음 (간단한 JS/Python 스니펫) |

| 통합 앱 수 (Number of Integrations) | 1,000+ (HTTP 노드로 모든 API 연동 가능) | 1,500+ (깊은 기능 지원) | 6,000+ (광범위하지만 기본 기능 위주) |

| 최적 사용 사례 (Optimal Use Case) | 복잡한 백엔드 프로세스, 대용량 데이터, 엄격한 규정 준수 | 정교한 마케팅/영업 자동화, 시각적 프로세스 매핑 | 빠른 SaaS 간 연결, 간단한 알림 |

2. n8n을 활용한 실무 사례

n8n의 실무 사례들은 단순한 작업 자동화를 넘어, 비즈니스의 핵심적인 문제를 해결하는 고부가가치 시스템을 구축할 수 있는 잠재력을 가지고 있습니다. 다음은 실무에 즉시 적용 가능한 혁신적인 사례입니다.

2-1. Delivery Hero – IT Ops 자동화

| 도입 전 | IT 팀이 사용자 계정 잠금 해제를 수작업으로 처리해야 했으며, 한 건당 약 35분 소요 |

|---|---|

| 도입 후 | Okta, Jira, Google Workspace API 호출을 자동화하여 한 건당 처리 시간을 20분으로 단축, 월 200시간 이상 절감 |

| 효과 | 반복적인 수작업 제거, IT 리소스 활용 효율 대폭 향상 |

2-2. StepStone – 데이터 통합 속도 25배 향상

| 도입 전 | 신규 파트너 API 연동에 2주 소요 |

|---|---|

| 도입 후 | 워크플로로 연동 시간을 2시간으로 줄여 25배 빠른 연동 실현 |

| 효과 | API 통합 작업의 민첩성과 확장성 강화 |

2-3. Musixmatch – 콘텐츠 변환 자동화

| 도입 전 | 대량의 가사 콘텐츠 변환을 수작업으로 처리 |

|---|---|

| 도입 후 | 워크플로로 자동 변환 처리, 첫 4개월 동안 엔지니어링 시간 47일 절감 |

| 효과 | 대규모 콘텐츠 운영 시 효율성과 자동화 수준 개선 |

2-4. Bordr, ChatHQ – 스타트업 자동화

| 도입 전 | 주문·문서·결제 등 모든 운영을 수작업 처리 |

|---|---|

| 도입 후 | Paperform, Stripe, Airtable 등과 연결한 자동 워크플로 구현, 수작업 제거, 수익 6자리 수로 성장 |

| 효과 | 최소 팀으로 대규모 운영 실현, 빠른 확장 지원 |

3. 전략적 의사결정 프레임워크

3-1. 통합 프로토콜의 진화

- 과거(레거시): 애플리케이션 간 통합은 직접 DB 쿼리, 파일 교환(ETL), 커스텀 포인트 투 포인트 커넥터 방식으로 이루어졌습니다.

- 중간 단계(현재까지 널리 사용): REST/GraphQL API + Webhook + 메시지 큐(비동기) 모델이 표준이 되어 ‘명시적 계약(스키마, 버전)’으로 시스템을 연결합니다.

- 최근 변화: LLM/AI가 ‘행동’(tools / function calls)을 직접 수행하도록 하는 기능이 늘어나면서, 단순한 API 호출 이상의 “모델-친화적” 통합 방식의 필요성이 대두되었습니다. 이 필요를 표준화하려는 시도가 Model Context Protocol (MCP)입니다. LLM 기반 에이전트가 외부 도구와 컨텍스트(파일, 기능, 권한)을 표준화된 방식으로 탐색·사용하도록 설계된 오픈 프로토콜입니다.

3-2. API 통신의 장점과 한계

① API 통신의 장점

- 유연한 연동과 확장성

- 사전 구축된 노드가 없어도 새로운 서비스나 내부 시스템과 쉽게 연결 가능합니다.

- 자유로운 요청 구성 및 데이터 처리

- HTTP 메서드, 인증, 쿼리/헤더 설정 등을 추가하여 요청을 자유롭게 구성할 수 있습니다.

- 페이지 네이션, JSON/텍스트 변환 등 대용량 데이터 처리 지원이 가능합니다.

- 신뢰성과 관리 용이성

- 명확한 스키마/버전 관리, 테스트· CI 파이프라인을 구축할 수 있습니다.

- OAuth2, TLS, rate limiting 등 보안 및 운영 지원 가능합니다.

- 예측 가능한 성능

- 동기/비동기 패턴으로 SLA 관리가 가능합니다.

② API 통신의 주요 한계

- 사전 정의된 구조 의존

- REST API는 엔드 포인트와 데이터 구조가 고정되어 있어, 클라이언트가 필요한 데이터만 자유롭게 가져오기가 어렵습니다.

- 새로운 기능이나 데이터 형식이 필요하면 서버 변경이 필요합니다.

- 복잡한 통합 관리

- 다양한 서비스와 연동할 때 엔드 포인트별로 요청을 관리해야 하므로 워크플로가 복잡해지고, 유지 보수 부담이 증가합니다.

- 인증 방식, 파라미터, 페이지 네이션 등 설정을 일일이 처리해야 합니다.

- 실시간 및 상태 기반 처리 한계

- 대부분의 REST API는 요청-응답 방식으로 동작하므로 실시간 데이터 처리나 상태 변화를 추적하는 데 제한이 있습니다. (Webhook, polling 등을 별도로 구현해야 하므로 복잡도 상승)

- LLM-친화성 부족

- 기존 API는 ‘사람-중심 UI/문서’ 기반으로 설계되었기 때문에 LLM이 안전하고 예측 가능하게 사용하기 어렵습니다.

3-3. API 통신 설계 방법론

- Credential 추상화

- OAuth2, API Key, JWT 등 다양한 인증 방식을 Credential 객체로 분리하여 관리합니다.

- 여러 노드에서 재사용할 수 있고, 보안 설정을 일관되게 유지할 수 있습니다.

- Operation 단위 명세

- list, get, create, update, delete, stream 등 사용자 친화적인 단위로 기능을 정의합니다.

- 복잡한 API 호출을 단순화하여 명확한 작업 단위로 노출합니다.

- 입력·출력 스키마 제공

- 각 Operation에 대해 입력/출력 JSON Schema를 정의하고 문서화합니다.

- 예시 데이터(Sample Payload)를 포함하여 개발자 경험(DX)을 개선합니다.

- 에러 처리 및 재시도 로직

- Idempotency Key를 지원하여 중복 실행을 방지합니다.

- 429(Too Many Requests), 5xx(Server Error) 응답 시 지수적 백오프(Exponential Backoff) 기반으로 재시도를 구현합니다.

- 페이징 및 스트리밍 처리

- 대량 데이터 처리 시 cursor 기반 페이징을 지원합니다.

- 실시간 데이터의 경우 Webhook 또는 Server-Sent Events(SSE) 기반 이벤트 스트리밍을 제공합니다.

- 로깅 및 관찰성(Observability)

- 요청/응답 로그를 기록하되, 민감 정보는 마스킹 처리합니다.

- 요청률(QPS), 오류율, 지연 시간(latency) 등의 메트릭을 수집하고 모니터링합니다.

3-4. MCP(Model Context Protocol)의 장점 및 한계

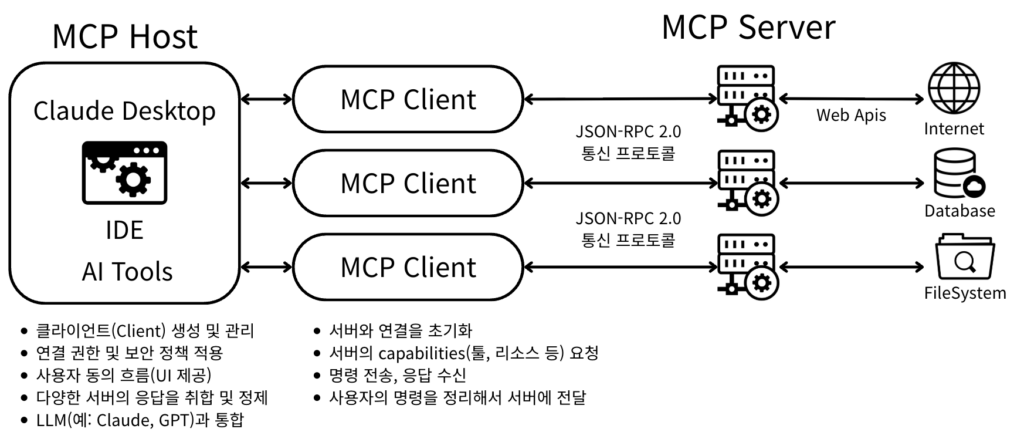

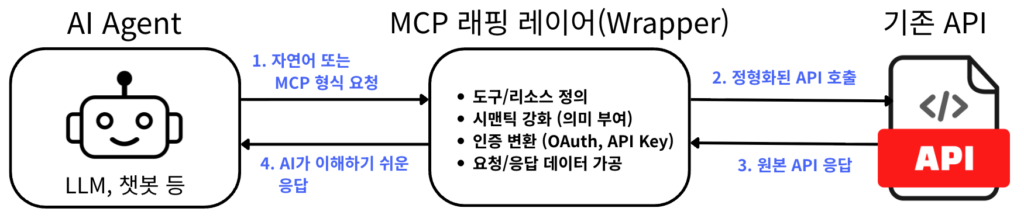

① 아키텍처 중심 요약

MCP는 LLM/AI 에이전트가 외부 시스템(파일 저장소, 데이터베이스, 서비스 API 등)을 표준화된 방식으로 “발견·질의·사용”할 수 있게 하는 오픈 표준입니다. MCP는 도구(툴)·리소스의 메타데이터와 작동 인터페이스를 모델에게 노출하고, 모델은 그 인터페이스를 통해 안전하게 행동을 요청할 수 있습니다.

| 구분 | 설명 |

|---|---|

| MCP 호스트(Host) | 사용자가 상호작용하는 AI 기반 애플리케이션 환경입니다. ㆍ전체 프로세스를 관리하고 연결을 조율하는 컨테이너 역할을 담당합니다. ㆍ사용자 입력을 받아 MCP 클라이언트에게 전달하고 응답을 조율합니다. |

| MCP 클라이언트(Client) | 호스트와 MCP 서버 사이에서 ‘중재자’ 역할을 합니다. ㆍ맥락(context) 관련 요청을 서버로 보내고 결과를 받아 호스트에 전달합니다. |

| MCP 서버(Server) | 외부 도구·데이터 소스·시스템을 MCP 표준 규격으로 노출하는 서비스입니다. ㆍ모델이 어떤 ‘도구(tools)’나 기능을 사용할 수 있는지 메타데이터로 제공하고, 실제 실행도 수행합니다. |

이러한 구성은 모듈화(modular), 보안(security), 확장성(scalability) 측면에서 우수하게 설계되어 있습니다.

② MCP의 장점

| 장점 | 설명 |

|---|---|

| 표준화된 연결 방식 | 기존에는 서비스마다 API 노드(커스텀 플러그인)를 따로 만들어야 했지만, MCP를 쓰면 공통 규격으로 여러 서비스/리소스를 연결할 수 있습니다. |

| 자동 도구 발견(Discovery) | LLM이 MCP 서버에 연결되면 사용 가능한 도구와 리소스를 자동으로 인식할 수 있어서, 매번 스키마를 직접 작성할 필요가 줄어듭니다. |

| 문맥(Context) 공유 | n8n에서 실행되는 워크플로나 노드 상태를 MCP를 통해 모델에 제공하면, 모델이 상황을 이해하고 더 똑똑하게 응답할 수 있습니다. |

| 재사용성과 확장성 | 한 번 MCP 인터페이스를 정의하면 다른 에이전트, 다른 워크플로에서도 그대로 활용할 수 있어 확장성이 높습니다. |

| 보안·제어 용이성 | API Key/OAuth 같은 인증을 모델이 직접 다루는 게 아니라 MCP 서버가 관리하기 때문에, 보안과 접근 제어를 중앙화할 수 있습니다. |

③ MCP의 주요 한계

| 한계점 | 설명 |

|---|---|

| 표준의 초기 단계 | ㆍMCP는 아직 새로운 표준이라 실제 지원하는 생태계(플러그인, 서버, 클라이언트)가 제한적입니다. ㆍ즉, Google Sheets 같은 주요 SaaS는 아직 직접 MCP를 지원하지 않습니다. |

| 성능 오버헤드 | ㆍJSON-RPC / SSE 같은 중간 계층을 거치므로, 직접 API 호출보다 응답 속도가 느릴 수 있습니다. ㆍ특히 대량 데이터 처리 시 비효율적일 수 있습니다. |

| 복잡성 증가 | ㆍ단순히 API Node 하나를 만드는 것보다, MCP 서버를 띄우고 스키마/Capabilities를 정의하는 게 더 복잡할 수 있습니다. ㆍ작은 규모 워크플로에는 과한 설계일 수 있습니다. |

3-5. MCP 서버 구현 방법론

| 방법론 | 설명 |

|---|---|

| 프로토콜 준수 | ㆍMCP 규약(JSON-RPC 기반 통신, stdio/HTTP/웹소켓 지원)을 반드시 준수 ㆍ표준 메시지 포맷 ㆍinitialize → 서버 초기화 ㆍlistTools / listResources → 제공 기능 카탈로그 노출 ㆍcallTool → 실제 작업 실행 ㆍreadResource → 리소스 접근 ㆍ일관된 request/response 구조 제공 |

| 도구/리소스 정의 | ㆍ서버가 제공할 도구(tools) 와 리소스(resources)를 명확하게 정의 ㆍ각 항목은 이름, 설명, 입력/출력 스키마(JSON Schema)를 포함해야 함  ㆍself-describing 구조여야 AI Agent가 자동으로 탐색 가능 |

| 보안/인증 | ㆍ민감 API 호출 시 Credential 분리 (API key, OAuth2, JWT 등) ㆍ불필요한 데이터 노출 방지 (로그 마스킹, 최소 권한 원칙) ㆍRate limiting 및 abuse 방지 로직 포함 |

| 에러 처리 & 안정성 | ㆍ예측 가능한 오류 응답 제공 (예: 400/401/429/500 등) ㆍIdempotency 지원 → 중복 요청에도 결과가 일관되게 유지되도록 처리 ㆍ백오프 & 재시도 정책 포함 (특히 429, 5xx 응답 시) |

| 확장성 & 유지보수 | ㆍ모듈형 구조 → 새로운 도구/리소스 추가가 쉬워야 함 ㆍ버전 관리 (ex: v1/getUser, v2/getUser) ㆍ테스트 가능한 구조 (샌드박스 모드 / mock responses 제공) |

| 관찰 가능성 (Observability) | ㆍ요청/응답 로깅 (개인정보는 마스킹) ㆍ메트릭 제공 (QPS, 오류율, 레이턴시 등) ㆍ헬스 체크 엔드 포인트 (/headthz) 제공 |

| 통신 채널 선택 (표준 권장) | ㆍ간단한 경우 → stdio (CLI/로컬 통합) ㆍ네트워크 서비스 → HTTP/JSON-RPC ㆍ실시간 스트리밍 필요 → WebSocket/SSE |

4. 하이브리드 전략: API + MCP

4-1. 하이브리드 모델의 필요성

하이브리드 모델의 핵심은 자동화의 효율성과 지능을 동시에 극대화하는 것입니다. 즉, 단순하고 반복적인 작업은 빠르고 저렴한 API로 처리하고, 복잡하고 예측 불가능한 문제는 유연한 MCP(AI 에이전트)에 위임하는 방식입니다.

구체적으로, 아키텍처는 즉각적인 피드백이 필요한 동기적 상호작용에는 API를 사용하고, 시스템의 회복 탄력성과 확장성을 높여야 하는 부분에는 이벤트 기반의 비동기 통신을 활용합니다. 이를 통해 시스템은 외부 요청에 신속하게 응답하면서도, 내부적으로는 복잡하고 시간이 많이 소요되는 작업을 효율적으로 처리할 수 있습니다.

| 구분 | API 기반 자동화 (반사 신경 🦾) | MCP 기반 AI Agent (의식적 사고 🧠) |

|---|---|---|

| 작동 방식 | 정해진 규칙에 따라 순차적으로 실행 | 상황을 추론하고 동적으로 다음 행동을 결정 |

| 장점 | 빠른 속도, 높은 신뢰성, 낮은 비용 | 유연성, 맥락 이해, 복잡한 문제 해결 |

| 단점 | 예외 상황 대처 불가, 경직된 구조 | 느린 속도, 높은 비용, 예측 불가능성 |

| 적합한 업무 | 데이터베이스 조회, 정형화된 알림 발송 | 비정형 고객 문의 분석, 맞춤형 보고서 생성 |

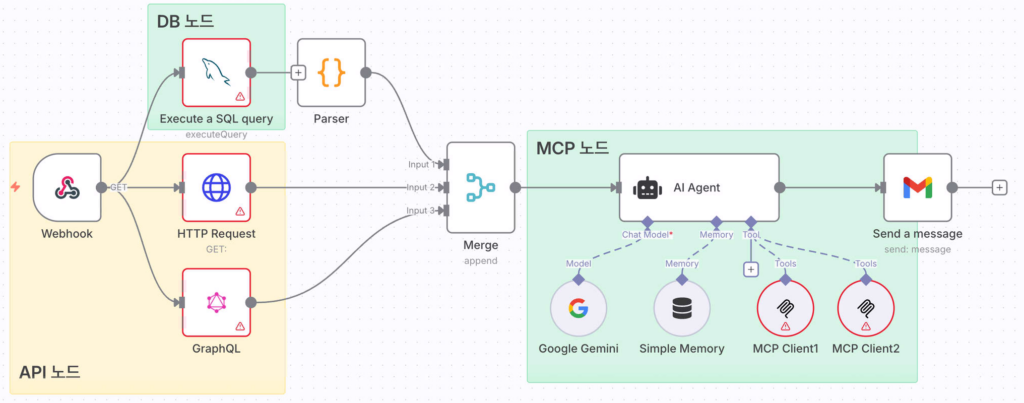

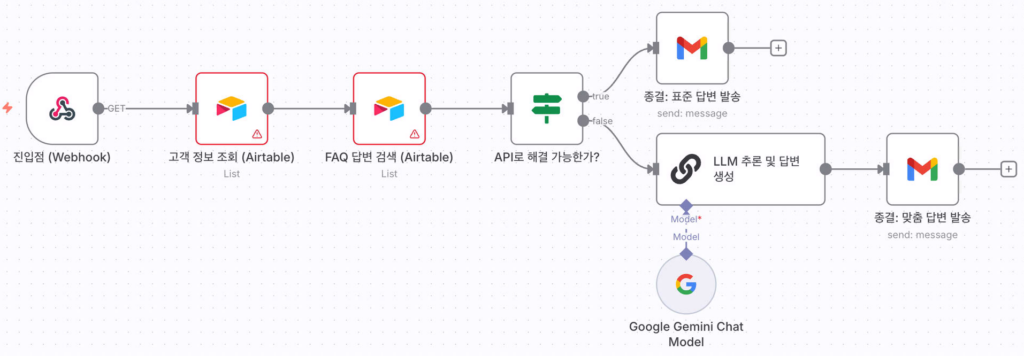

4-2. “API-First & Agent-Fallback” 모델

n8n에서 이 하이브리드 전략을 구현하기 위한 가장 효과적인 아키텍처는 “API 우선 처리 및 에이전트 대체(API-First & Agent-Fallback)” 모델입니다.

- 진입점 (Trigger)

- Webhook, Schedule 등을 통해 워크플로가 시작됩니다. (예: 신규 고객 문의 이메일 수신)

- 1단계: 정형 데이터 처리 (API Path)

- 우선 이메일 주소로 데이터베이스(Airtable, Google Sheets 등)나 CRM에서 고객 정보를 조회합니다. (HTTP Request 또는 전용 노드 사용)

- 문의 내용에서 키워드를 추출하여 기존 FAQ 데이터베이스와 일치하는 답변이 있는지 확인합니다.

- 이 단계는 빠르고 비용이 저렴한 API 호출로만 구성됩니다.

- 분기점 (Decision Point – The Router)

- IF 또는 Switch 노드를 사용하여 1단계의 처리 결과를 검증합니다.

- 분기 조건

- (성공) API로 해결 가능한 경우: DB에 고객 정보가 있고, FAQ에 명확한 답변이 있는가?

- (실패/예외) MCP 위임이 필요한 경우: 신규 고객이거나, 문의 내용이 복잡하고 비정형적인가?

- 2단계: 비정형 처리 및 추론 (MCP Path)

- 분기점에서 ‘실패’ 경로로 들어온 데이터(고객 문의 내용, 1단계 처리 결과 등)를 LLM(ChatGPT 등) 노드에 전달합니다.

- LLM은 MCP 프레임워크에 따라 상황을 분석합니다.

- 추론(Reasoning): “신규 고객의 복잡한 기술 문의로군. 관련 기술 문서를 검색해서 답변을 생성해야겠다.”

- 도구 사용(Tool Use): HTTP Request 노드를 통해 내부 기술 문서 DB를 검색하는 API(Tool)를 호출합니다.

- 답변 생성: 검색된 기술 문서 내용과 고객의 질문을 종합하여 맞춤형 답변 초안을 생성합니다.

- 종결점 (Final Action)

- API 경로에서 생성된 표준 답변 또는 MCP 경로에서 생성된 맞춤형 답변을 고객에게 이메일로 발송하거나, 담당자에게 알림을 보냅니다.

4-3. “MCP Wrapping Layer Pattern” 모델

- 기존 API Layer (Existing APIs)

- 기업이나 서비스가 이미 보유한 REST/GraphQL API, gRPC, SOAP 등

- 인증, 권한, 버전 관리, 모니터링은 기존 API 관리 방식 그대로 유지

- MCP Server (Provider Layer)

- MCP 서버는 기존 API를 Wrapping

- API → MCP 표준으로 변환:

- API 엔드 포인트를 MCP tool로 노출

- API의 데이터 리소스를 MCP resource로 변환

- 필요시 API 응답을 LLM-friendly JSON Schema로 정규화

4-4. 향후 발전 방향

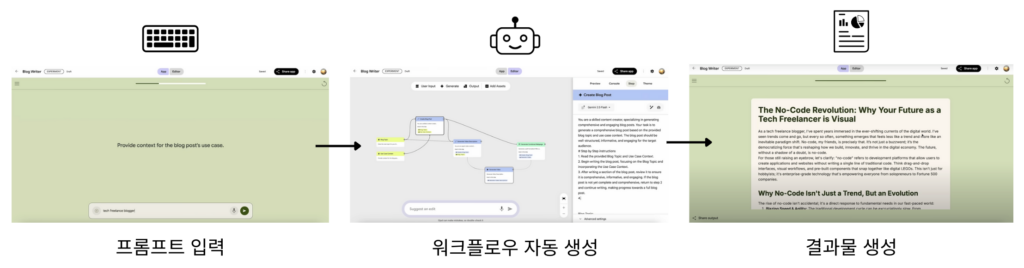

- 동적 워크플로 생성 및 수정

- 궁극적으로 AI 에이전트가 주어진 목표를 달성하기 위해 필요한 n8n 워크플로를 스스로 구성하거나, 기존 워크플로의 문제를 진단하고 수정하는 단계로 발전할 것입니다. 예를 들어, “매주 월요일 영업 실적을 취합해서 슬랙으로 보고해 줘”라는 자연어 명령만으로 에이전트가 필요한 DB 연결, 데이터 처리, 슬랙 전송 노드를 포함한 워크플로를 동적으로 생성하는 것입니다. (Google Laps의 Opal 참고)

- 지능형 비용-성능 최적화

- 에이전트가 작업의 복잡도를 스스로 판단하여 최적의 LLM 모델을 동적으로 선택하게 될 것입니다. 단순한 분류 작업에는 빠르고 저렴한 모델(예: Claude 3 Haiku)을 사용하고, 복잡한 추론이 필요할 때는 고성능 모델(예: GPT-5)을 사용하는 식으로 비용과 성능을 실시간으로 최적화합니다.

- 고도화된 관찰 가능성 (Observability)

- 에이전트가 왜 그런 결정을 내렸는지(Chain of Thought), 어떤 도구를 사용했는지 그 과정을 시각적으로 쉽게 추적하고 디버깅할 수 있는 기능이 강화될 것입니다. 이는 AI 에이전트의 예측 불가능성을 제어하고 신뢰도를 높이는 데 필수적입니다.

Conclusion

API와 MCP를 결합한 하이브리드 전략은 당분간 서비스 자동화의 가장 현실적인 해법입니다. API는 빠르고 저렴하게 단순 업무를 처리하는 데 탁월하고, MCP는 복잡하고 비정형적인 문제를 풀어내는 데 강점이 있습니다. 특히 “API-First & Agent-Fallback” 모델은 두 가지의 장점을 균형 있게 살린 구조라 기업 환경에서 실질적인 효용을 낼 수 있다고 봅니다. 여기에 기존 API를 MCP 표준으로 감싸는 “MCP Wrapping Layer Pattern”까지 더해진다면, 앞으로의 확장성은 더욱 커질 것입니다.

나아가 에이전트가 워크플로를 스스로 만들고 비용과 성능까지 조율하는 시대가 오면, 자동화는 단순한 효율화가 아니라 기업 운영 방식을 바꿔버리는 전략적 무기가 될 것입니다.

References

- https://n8n.io/

- https://docs.n8n.io/

- https://cipherprojects.com/blog/posts/n8n-vs-zapier-vs-make-automation-comparison

- https://cloud.google.com/apis/design?hl=ko

- https://www.digitalapplied.com/blog/zapier-vs-make-vs-n8n-automation-comparison

- https://swagger.io/resources/articles/adopting-an-api-first-approach

- https://modelcontextprotocol.io/docs/getting-started/intro

- https://medium.com/%40tuguidragos/how-businesses-use-n8n-real-world-workflows-and-case-studies-4f8268e84e06

- https://innitor.ai/blog/n8n-8-inspiring-use-cases

- https://opal.withgoogle.com/landing/

- https://uxwing.com/