요약

이 글은 한컴 인공지능기술팀이 제안한 SLM(경량 언어모델) 기반 Agentic AI 구조, P–C–G(Planner–Caller–Generator)의 설계와 성능을 소개합니다. 대형 언어모델(LLM)의 비용·응답 지연·자원 소모 문제를 해결하기 위해, 한컴은 모델의 역할을 세분화한 효율적인 구조를 제안했습니다. P–C–G는 한 번의 초기 계획 후 필요한 경우에만 재계획을 수행해 토큰 사용량과 지연 시간을 줄이며, 한국어 환경에서 GPT-4o-mini 수준의 성능을 유지했습니다. 본 글은 이 구조의 핵심 원리와 실험 결과, 그리고 향후 적용 방향을 다룹니다.

1. 연구 배경

최근 LLM(대형 언어모델)의 발전은 놀라울 정도로 빠릅니다. 하지만 실제 서비스에 적용하려고 하면, 비용·지연·보안 리스크라는 현실적 제약이 여전히 존재합니다.

한컴 인공지능기술팀은 이러한 문제를 해결하기 위해 경량 언어모델(SLM) 기반의 새로운 Agentic AI 구조를 제안했습니다.

핵심 질문은 세 가지입니다.

- LLM이 아닌 SLM으로도 실용 수준의 Agentic AI를 구현할 수 있을까?

- 역할을 분리한 구조(Planner–Caller–Generator)가 효율성을 확보할 수 있을까?

- 도구 누락이나 파라미터 결손과 같은 불완전한 환경에서도 안정적으로 작동할까?

2. 기존 Agentic AI의 한계

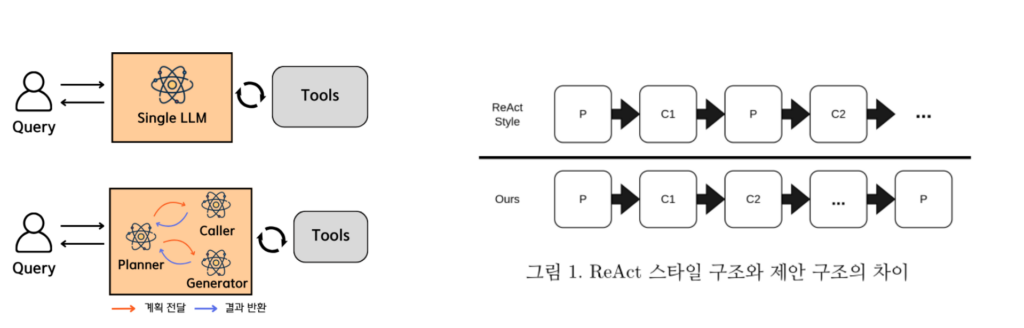

기존의 Agentic AI는 하나의 대형 모델이 모든 역할(계획, 호출, 응답 생성)을 수행하는 구조입니다.

이 방식은 단순하지만, 다음과 같은 문제가 있습니다.

- 모든 기능이 한 모델에 집중되어 복잡한 작업에서 부하가 발생

- 모델 크기 증가로 인한 비용·자원 소모 확대

- 느린 응답 속도와 서비스 적용의 부담

결국, 대형 모델 중심의 구조는 효율성과 확장성의 병목이 됩니다.

이를 해결하기 위해 한컴 인공지능기술팀은 모델의 역할을 분리한 새로운 구조를 제안했습니다.

3. P–C–G 구조: 역할을 분리한 경량 에이전트 설계

P–C–G 구조는 에이전트의 세 가지 역할을 명확히 분리합니다.

| 모듈 | 역할 | 핵심 기능 |

|---|---|---|

| Planner | 실행 계획 수립 | 사용자 요청 분석 → 사용할 도구와 호출 순서 결정 |

| Caller | 도구 호출 및 인자 검증 | Planner의 계획을 실행하고 결과를 수집 |

| Generator | 결과 통합 및 응답 생성 | 중간 결과를 종합해 자연어 응답 생성 |

이 구조는 기존 ReAct 스타일과 달리, 한 번의 초기 계획(initial plan) 을 세운 뒤 필요한 경우에만 제한적 재계획(replanning)을 수행합니다.

💡참고

기존 ReAct 스타일(Reinforce + Act) 구조는 “계획(Plan)과 행동(Action)을 매 단계마다 반복하며 도구를 호출하는 방식”입니다.

즉, 매 단계마다 새로운 계획을 세우고 실행하기 때문에 복잡한 문제에서는 추론 반복(looping)이 증가하고, 토큰 낭비와 지연(latency)이 발생하는 단점이 있습니다.예를 들어, ReAct는 다음과 같은 형태로 작동합니다.

Plan → Call → Observe → Plan → Call → Observe → … → Final Answer

이처럼 매번 다시 계획을 세우기 때문에 처리 효율이 낮습니다.

P–C–G 구조는 이러한 반복을 제거하고, 불필요한 호출을 최소화해 토큰 사용량과 지연 시간을 동시에 절감할 수 있습니다.

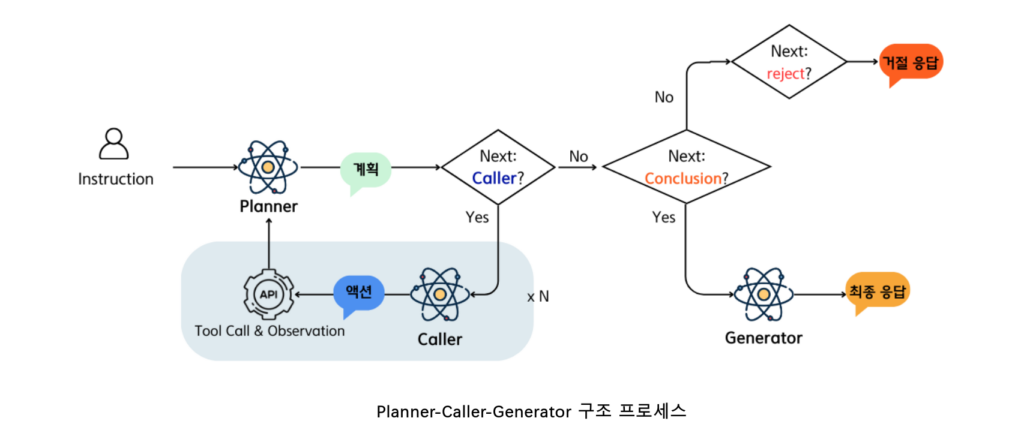

프로세스는 다음과 같습니다.

- 사용자의 질문이 들어오면 먼저 Planner가 전체 계획을 수립합니다.

- 이후 다음 단계가 Caller라면, 계획된 호출 횟수에 따라 도구를 실행하고 그 결과를 반환합니다.

- Planner는 이 결과를 다시 검토해 현재 정보로 충분한지, 추가 도구 호출이 필요한지 판단합니다.

- 최종적으로 필요한 정보가 모두 확보되면 Generator가 결과를 정리하고 사용자에게 응답을 제공합니다.

이 일련의 과정은 불필요한 반복 호출을 줄이고, 모델이 스스로 계획–실행–응답의 논리적 흐름을 유지할 수 있도록 설계되어 있습니다.

4. 평가 방법

데이터셋 구성

한국어 환경에서의 도구 활용 능력을 공정하게 평가하기 위해, 실제 서비스와 유사한 데이터셋을 구축했습니다.

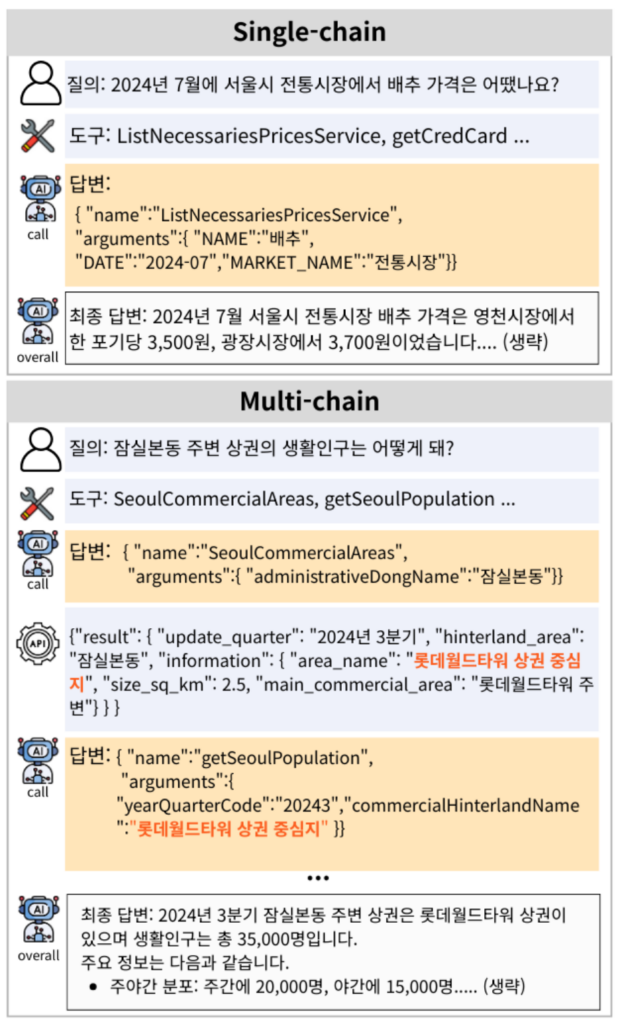

- 총 400개 평가 항목 (Single-chain, Multi-chain, Missing Parameters, Missing Functions 각 100개)

- 도구 정의: 공공데이터 API 447종 기반

- 평가 조건: 한국어 질의 및 한국어 파라미터 환경

- 판정 프로토콜: LLM-as-a-Judge 방식으로 5회 반복 평균

| 유형 | 설명 |

|---|---|

| Single-chain | 하나의 도구만 사용하는 단순 호출 |

| Multi-chain | 여러 도구를 순차적으로 사용하는 연쇄 호출 |

| Missing Parameters | 필수 입력값이 누락된 경우 |

| Missing Functions | 필요한 도구 자체가 제공되지 않은 경우 |

평가 지표 체계

| 지표 | 의미 |

|---|---|

| Call Accuracy | 올바른 도구 선택 및 인자 생성의 정확성 |

| Generate Accuracy | 최종 응답의 사실성, 구조적 완결성, 톤 |

| Task Success Rate (TSR) | 질의 의도 충족, 논리적 도구 사용, 응답 완전성의 종합 평가 |

| Tokens Average / Latency | 효율성 지표 (질문 1건 처리 시 평균 토큰·지연시간) |

5. 주요 실험 결과

5.1 모듈별 성능

| Model | Single-chain | Multi-chain | Missing Func (%) | Missing Params (%) | ||

|---|---|---|---|---|---|---|

| Overall (%) | Call Acc. (%) | Overall (%) | Call Acc. (%) | – | – | |

| GPT-4o-mini | 87.4 | 86.0 | 67.0 | 33.0 | 65.0 | 76.8 |

| Exaone-4.0-32B-AWQ | 80.2 | 88.6 | 56.6 | 32.6 | 75.2 | 53.6 |

| Qwen3-14B | 88.4 | 93.0 | 58.2 | 28.4 | 90.0 | 76.8 |

| Qwen3-8B | 87.8 | 90.6 | 47.0 | 20.4 | 87.2 | 56.8 |

| Ours(P–C–G) | 91.2 | 95.6 | 62.4 | 33.8 | 91.2 | 66.6 |

- Single-chain에서는 최고 수준의 정확도를 달성

- Multi-chain에서도 안정적인 성능 유지

- Missing Functions 시나리오에서 뛰어난 제약 인식 능력 확인

5.2 효율성 평가

| 모델 | Task Success Rate(%) | 평균 토큰 수 | 응답 시간(초) |

|---|---|---|---|

| GPT-4o-mini | 79.3 | 3747.6 | 7.9 |

| EXAONE-4.0-32B-AWQ | 78.6 | 5337.8 | 9.6 |

| Qwen3-8B | 72.4 | 4950.3 | 6.1 |

| P–C–G (Qwen-8b) | 79.7 | 4360.3 | 9.1 |

경량 모델(SLM)임에도 불구하고, GPT-4o-mini 수준의 Task Success Rate를 달성했으며, 평균 토큰 사용량을 12~22% 절감했습니다.

6. 구조 비교: 기존 방식 vs 제안 방식

| 기존 ReAct 스타일 | 제안한 P–C–G 구조 |

|---|---|

| 매 단계마다 계획 수립 반복 | 초기 계획 + 필요 시 제한적 재계획 |

| 높은 토큰 소비, 지연 증가 | 토큰 절감 및 효율성 향상 |

| 단일 모델 과부하 | 역할 분리로 안정성 확보 |

7. 결론 및 향후 방향

이번 연구를 통해 다음과 같은 결론을 얻었습니다.

- 역할 분리만으로도 SLM이 LLM 수준의 도구 활용 능력을 보일 수 있음

- 한국어 중심 환경에서도 실용적인 Agentic AI 구현 가능성 입증

- 비용 효율성과 응답 속도 측면에서 실용적 수준 달성

향후 연구에서는 다음의 개선 방향을 고려하고 있습니다.

- Planner 모듈 경량화 및 캐싱을 통한 지연 단축

- 누락된 파라미터 보완 능력 향상

- 보안 및 프롬프트 인젝션 대응 강화

8. 연구 의의

이번 연구는 대형 모델 중심의 Agentic AI 흐름 속에서, “작지만 구조적으로 강한 AI”의 가능성을 실증한 사례입니다.

SLM 기반의 Planner–Caller–Generator 구조는 한국어 서비스 환경에서 정확성, 효율성, 비용 절감을 모두 만족시키는 새로운 대안으로 자리 잡을 수 있음을 보여주었습니다.

참고 자료

- 논문: SLM-Based Agentic AI with P–C–G: Optimized for Korean Tool Use (arXiv, 2025)

- 발표: 한글 및 한국어 정보처리학술대회, 2025년 10월 2일